Una supuesto frecuente de los modelos de Gestión de Inventarios sencillos es considerar que la demanda a la cual una empresa se enfrenta es conocida, es decir, no existe incertidumbre. Este supuesto da origen a Modelos Deterministas de inventarios como el de Cantidad Económica de Pedido (EOQ) con o sin Descuentos por Cantidad, Producción y Consumo Simultaneo (POQ), entre otros.

Si bien los Modelos Deterministas para la Gestión de Inventarios resultan ser útiles, en la mayor parte de las aplicaciones prácticas, es muy difícil mantener como razonable y representativo el supuesto de una demanda constante y conocida.

Para enfrentar esta situación se proponen Modelos Estocásticos, es decir, donde la demanda presenta un comportamiento aleatorio el cual puede o no ser estimado por una distribución de probabilidad conocida o en su defecto por una distribución empírica.

En este contexto de demanda aleatoria no se puede asegurar a ciencia cierta si una determinada cantidad de unidades en inventario serán suficientes para satisfacer los requerimientos de demanda de un producto. Sin embargo, si se logra perfilar el comportamiento de la demanda (aleatoria) se estará en condiciones de poder estimar que tan probable es satisfacer la demanda dada una cierto tamaño del inventario.

Uno de los indicadores de gestión que se utiliza frecuentemente es el Instock, el cual bajo un escenario de demanda con incertidumbre indica la probabilidad de satisfacer en forma íntegra la demanda (es decir, evitar quiebres de stock) para un determinado nivel de inventario.

Ejemplo del Cálculo del Instock

Para graficar este concepto consideremos que una empresa tiene 900 unidades de un producto en inventario y enfrenta una demanda por el mismo que se puede representar por una Distribución Normal con media 800 unidades () y Desviación Estándar de 100 unidades (

). Nos interesa calcular la Probabilidad de Instock, es decir, la probabilidad que la demanda sea menor o igual a 1.000 unidades:

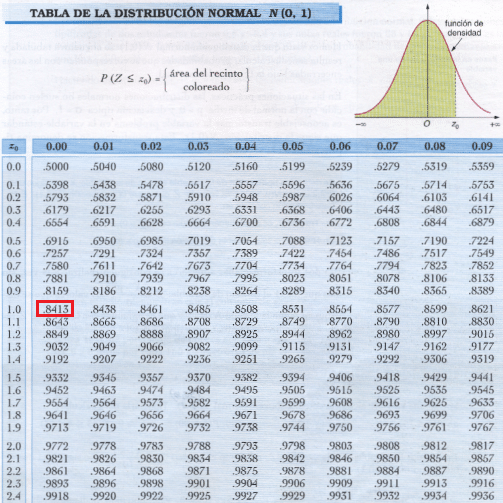

La Probabilidad de Instock por tanto es de un 84,13%. Para obtener la probabilidad asociada a un determinado valor de Z utilizando la Distribución Normal Estándar podemos utilizar una tabla de probabilidad que frecuentemente se incluyen como anexos en los libros de probabilidad básica o en su defecto podemos utilizar la fórmula de Excel =DISTR.NORM.ESTAND(Z). (En nuestro caso Z=1 destacado con color rojo en la tabla a continuación).

De este modo, la probabilidad de incurrir en un quiebre de stock dado un inventario de Q=900 unidades es de un 15,87% que se representa como el área achurada a la derecha de las 900 unidades.